Dos estudiantes universitarios de UW ganaron $ 10,000 por construir un guante cargado de gadgets que traduce los gestos del lenguaje de señas en audio.

Un par de estudiantes de la Universidad de Washington hicieron un guante que traduce gestos en lenguaje de señas americano (ASL) al inglés y lo habla a través de oradores. El guante SignAloud les ganó un Premio de Lemelson-MIT Student de $ 10,000 y atención internacional. Ahora están descubriendo cómo perfeccionar sus dispositivos para el bien social … y asegurarse de que aprueben sus exámenes universitarios.

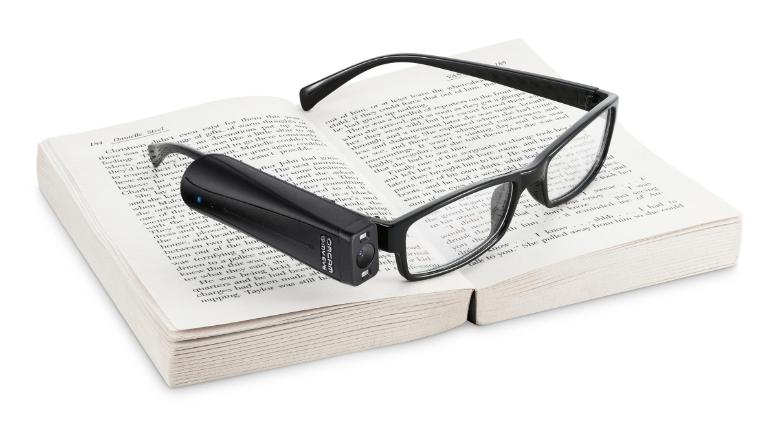

El guante SignAloud captura gestos ASL con sensores que miden todo, desde las coordenadas XYZ hasta la forma en que los dedos se flexionan o doblan. Los datos del sensor se envían a través de Bluetooth a una computadora cercana y se envían a algoritmos de codificación que categorizan los gestos, que se traducen al inglés y luego se los habla por el altavoz. Pero el co-creador Navid Azodi enfatiza que SignAloud todavía está en una fase de prototipo.

“Tenga en cuenta que de ninguna manera hemos capturado todo el lenguaje y no estamos cerca de eso”. [ASL] es más que solo palabras y frases, y lo sabemos. Tiene estructuras gramaticales complejas. Lo que finalmente queremos obtener es que SignAloud clasifique la mayoría del idioma “, dice Azodi.

https://www.youtube.com/watch?v=l01sdzJHCCM

Los dos creadores, Azodi y su compañero de segundo año Thomas Pryor, planearon y construyeron SignAloud en sus dormitorios y CoMotion MakerSpace de la escuela. Después de una primera versión aproximada construida en cartón y cuerda, juntaron el prototipo actual de trabajo por alrededor de cien dólares en partes.

“Muchos de los dispositivos de traducción de lenguaje de señas que ya existen no son prácticos para el uso diario. Algunos usan entrada de video, mientras que otros tienen sensores que cubren todo el brazo o el cuerpo del usuario “, dice Pryor en un comunicado de prensa de UW .

Innovar más allá de las limitaciones existentes es lo que le ganó al equipo el premio de $ 10,000, que Azodi no está seguro de cómo van a gastar. El dinero podría ayudarles a pagar su matrícula o tal vez incluso conseguirles una buena cena, Azodi bromea, pero refinar su dispositivo es la máxima prioridad. Ambos están motivados por las posibilidades de SignAloud, como un dispositivo de entrada y una herramienta de empoderamiento.

“La comunicación es un derecho humano fundamental”, dice Azodi, cuya experiencia personal ayudó a informar la herramienta. “Cuando era joven, en realidad no hablé durante unos siete años de mi vida. Tenía siete años cuando finalmente comencé a hablar. Tuve esa barrera de comunicación por una buena cantidad de tiempo “.

Azodi y Pryor se conocieron cuando eran novatos. Compartieron el deseo de devolverle algo al mundo utilizando sus talentos de ingeniería y su considerable experiencia . Azodi ha sido pasante de sistemas para la NASA, un líder tecnológico para UW Information Technology y un representante del campus para Apple; Pryor ha tenido pasantías en Raytheon y Boeing, es investigador de pregrado en el Laboratorio de estructuras compuestas y es un líder de software en el equipo de robótica de Husky.

Antes de compilar la próxima versión de SignAloud, Azodi y Pryor van a considerar las críticas que recibieron a medida que las noticias sobre su subvención se volvieron globales. Azodi lamenta que el dispositivo fue retratado como una herramienta que hablaría por las personas que no pueden hablar.

![[SignAloud]](https://images.fastcompany.net/image/upload/w_596,c_limit,q_auto:best,f_auto,fl_lossy/fc/3059616-inline-p-these-students-built-a-glove-that-translates-sign-language-into-english.jpg)

“[SignAloud] no es algo que hablará por ellos. Ellos tienen una voz y hablan. Honestamente, hablan mucho más fluidamente de maneras dinámicas y hermosas utilizando sus cuerpos “, dice Azodi. “Esta es una herramienta más para romper esas barreras entre el lenguaje físico de ASL y el inglés o el español”.

SignAloud podría incluso ayudar a traducir ASL a otros idiomas, o ser utilizado como un dispositivo de entrada puro de ASL en una computadora, dice Azodi. Incluso en su estado actual, SignAloud también podría funcionar como una herramienta de enseñanza para las personas que desean aprender ASL, ya que podría darles a los estudiantes información instantánea sobre lo que realmente estaban firmando.

Teniendo en cuenta los comentarios internacionales que han recibido, Azodi está decidida a asegurarse de que el equipo haga los deberes para aprender la sintaxis profunda de ASL, algo con lo que probablemente contraten a un experto para que los ayude. Azodi y Pryor sabían que usar un dispositivo para traducir ASL sería un desafío, pero no anticiparon la dificultad que encontrarían a la hora de rastrear los matices del lenguaje. Y las críticas que recibieron después de que SignAloud fuera publicitado por la prensa los sorprendieron.

“Ninguna de mis experiencias previas puede compararse con ser puesto en el punto de mira nacional y tener personas en todo el mundo lanzando sus críticas y puntos de vista sobre él. Me abrió los ojos a mucho más “, dice Azodi. “Ese proceso de aprendizaje fue uno de, si no la experiencia más humillante. La gente lo llamó un dispositivo milagroso, y no lo es. No se trata de ayudar a las personas; ellos no necesitan ayuda. Se trata de cómo la tecnología puede ser accesible e inclusiva. Es solo un medio de construir puentes y romper barreras “.

No toda la atención que el dúo recibió fue negativa: gracias a la cobertura de los medios, Azodi y Pryor enfrentan una gran cantidad de ofertas de asociación e inversión. Pero no están precipitándose en nada. Después de todo, como estudiantes de segundo año de la universidad de 19 años, todavía tienen que preocuparse por cosas normales. Van a progresar en SignAloud, pero tienen que trabajar en su calendario de exámenes.

“Las oportunidades para algo como esto son increíbles, ni siquiera puedo categorizar a dónde puede llegar esto. ¿Cuál es la mejor opción para nosotros usando lo que sabemos y lo que podemos hacer? “, Dice Azodi. “No te daré una respuesta definitiva. Somos solo un par de estudiantes universitarios. Acabo de tener exámenes parciales y estamos preocupados acerca de cómo llegar a nuestras mayores “.

https://youtube/l01sdzJHCCM