Larry Hardesty | Oficina de noticias del MIT

La retroalimentación de audio ayuda al usuario a escanear el dedo a lo largo de una línea de texto, que el software convierte a voz.

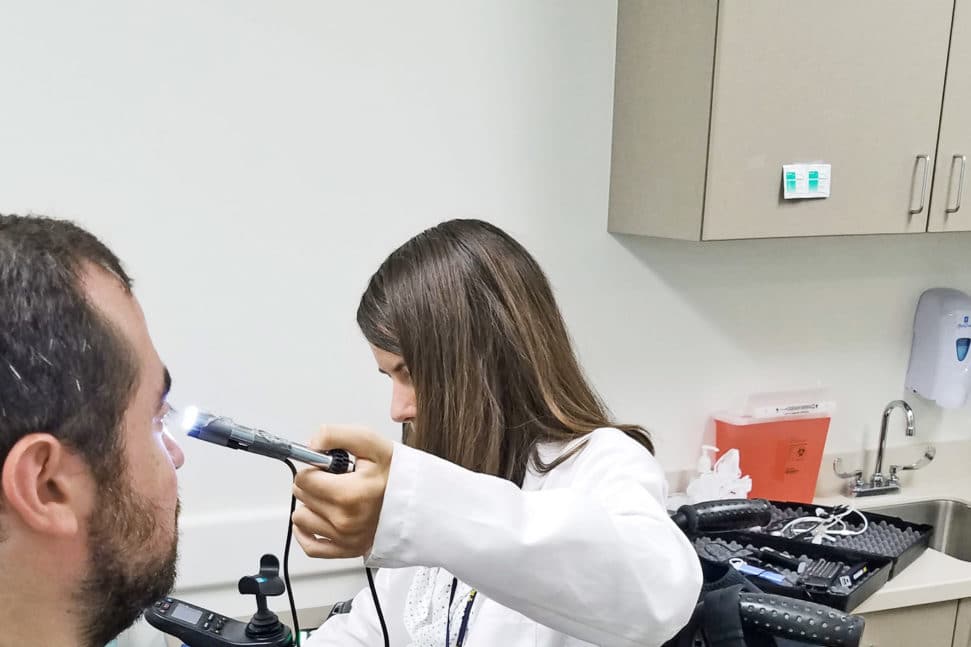

Los investigadores del MIT Media Laboratory han creado un prototipo de dispositivo montado en el dedo con una cámara incorporada que convierte el texto escrito en audio para usuarios con discapacidad visual. El dispositivo proporciona retroalimentación, ya sea táctil o audible, que guía el dedo del usuario a lo largo de una línea de texto, y el sistema genera el audio correspondiente en tiempo real.

“Realmente necesitas tener un acoplamiento estrecho entre lo que la persona escucha y dónde está la punta del dedo”, dice Roy Shilkrot, estudiante graduado del MIT en artes y ciencias de los medios y, junto con Jochen Huber, post-doctoral de Media Lab, autor principal de un nuevo artículo describiendo el dispositivo. “Para usuarios con discapacidad visual, esta es una traducción. Es algo que traduce lo que el dedo está “viendo” al audio. Realmente necesitan una retroalimentación rápida y en tiempo real para mantener esta conexión. Si está roto, rompe la ilusión “.

Huber presentará el documento en la conferencia Computer-Human Interface de la Asociación para Computadoras en abril. Los coautores de él y Shilkrot son Pattie Maes, la profesora Alexander W. Dreyfoos en Artes y Ciencias de los Medios del MIT; Suranga Nanayakkara, profesor asistente de desarrollo de productos de ingeniería en la Universidad de Tecnología y Diseño de Singapur, quien fue postdoc y luego profesor visitante en el laboratorio de Maes; y Meng Ee Wong de la Universidad Tecnológica de Nanyang en Singapur.

El documento también informa los resultados de un estudio de usabilidad realizado con voluntarios con problemas de visión, en el que los investigadores probaron varias variaciones de su dispositivo. Uno de ellos incluía dos motores hápticos, uno en la parte superior del dedo y el otro debajo. La vibración de los motores indica si el sujeto debe subir o bajar el dedo de seguimiento.

Otra versión, sin los motores, en su lugar usaba comentarios de audio: un tono musical que aumentaba de volumen si el dedo del usuario comenzaba a alejarse de la línea de texto. Los investigadores también probaron los motores y el tono musical en conjunto. Sin embargo, no hubo consenso entre los sujetos sobre qué tipos de retroalimentación fueron más útiles. Por lo tanto, en el trabajo en curso, los investigadores se concentran en los comentarios de audio, ya que permite un sensor más pequeño y ligero.

Línea de fondo

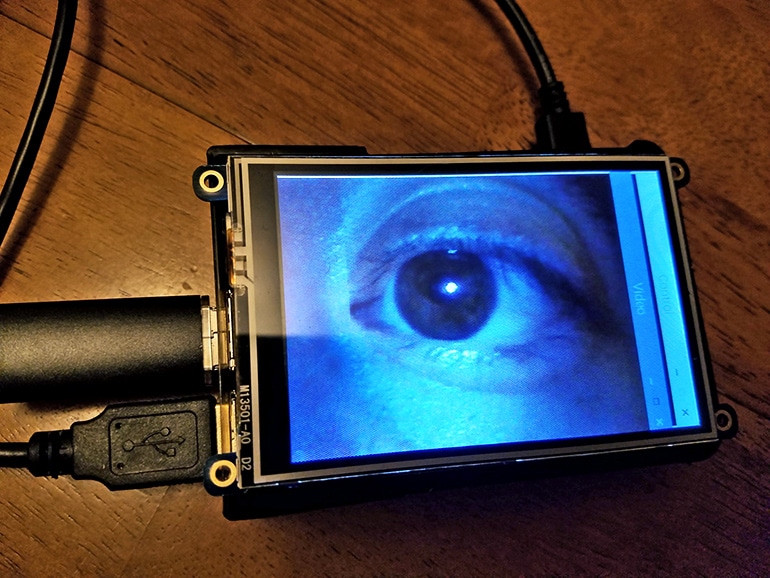

La clave del rendimiento en tiempo real del sistema es un algoritmo para procesar la alimentación de video de la cámara, que Shilkrot y sus colegas desarrollaron. Cada vez que el usuario coloca su dedo al comienzo de una nueva línea, el algoritmo realiza una serie de conjeturas sobre la línea base de las letras. Como la mayoría de las líneas de texto incluyen letras cuyos fondos descienden por debajo de la línea base, y debido a que las orientaciones sesgadas del dedo pueden hacer que el sistema confunda las líneas cercanas, esas conjeturas serán diferentes. Pero la mayoría de ellos tienden a agruparse, y el algoritmo selecciona el valor mediano del grupo más denso.

Ese valor, a su vez, limita las conjeturas que el sistema realiza con cada nueva trama de video, a medida que el dedo del usuario se mueve hacia la derecha, lo que reduce la carga computacional del algoritmo.

Dada su estimación de la línea base del texto, el algoritmo también rastrea cada palabra individual cuando se desliza más allá de la cámara. Cuando reconoce que una palabra se coloca cerca del centro del campo de visión de la cámara, lo que reduce la distorsión, recorta solo esa palabra de la imagen. La estimación de línea de base también permite que el algoritmo realinee la palabra, compensando la distorsión causada por los ángulos de cámara de bicho raro, antes de pasarla a un software de código abierto que reconoce los caracteres y traduce las palabras reconocidas al habla sintetizada.

En el trabajo reportado en el nuevo documento, los algoritmos fueron ejecutados en una computadora portátil conectada a los dispositivos montados en los dedos. Pero en el trabajo en curso, Marcel Polanco, un estudiante de maestría en ciencias de la computación e ingeniería, y Michael Chang, estudiante de pregrado en informática participando en el proyecto a través del Programa de Oportunidades de Investigación de pregrado del MIT, están desarrollando una versión del software que se ejecuta en un teléfono Android , para hacer que el sistema sea más portátil.

Los investigadores también descubrieron que su dispositivo podría tener aplicaciones más amplias de lo que inicialmente se habían dado cuenta. “Desde que comenzamos a trabajar en eso, nos resultó obvio que cualquiera que necesite ayuda con la lectura puede beneficiarse de esto”, dice Shilkrot. “Recibimos muchos correos electrónicos y solicitudes de organizaciones, pero también solo de padres de niños con dislexia, por ejemplo”.

“Es una buena idea usar el dedo en lugar del movimiento de los ojos, porque los dedos son, como el ojo, capaces de moverse rápidamente con intención en xey y pueden escanear cosas rápidamente”, dice George Stetten, un médico e ingeniero con articulaciones. nombramientos en el Instituto de Robótica de Carnegie Mellon y en el Departamento de Bioingeniería de la Universidad de Pittsburgh, que está desarrollando un dispositivo montado en los dedos que brinda a los usuarios con discapacidad visual información sobre objetos distantes. “Estoy muy impresionado con lo que hacen”.